Foto: Pixabay

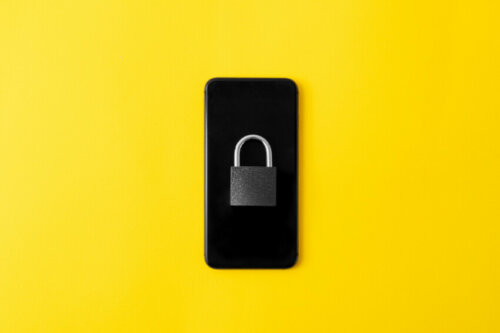

edním mechanismem, který chce Apple použít je lustrace fotografií, které mají uživatelé ve svém iCloudu, respektive ve svých telefonech. Tento mechanismus se jmenuje CSAM, což je jen zkratka pro Child Sexual Abuse Material. Z názvu je pak jasně patrné, že cílem je hlavně filtrovat materiály, kde se vyskytuje sexuální zneužívání dětí.

Tuto funkci pak vyvinuli vývojáři Applu společně s americkým Národním centrem pro pohřešované a zneužívané děti. Tento národní úřad dal Applu k dispozici fotografie zachycující dětskou pornografii, aby vývojáři Applu mohli následně nechat umělou inteligenci zdokonalit své schoponosti.

Foto: Pixabay

V reálu pak bude CSAM snímky kontrolovat ještě před tím, než je odešlete do iCloud Photos. Při zaznamenání nevhodného obsahu bude snímek předán společnosti Apple, která ho dále postoupí úřadům činným v trestném řízení. Podle mluvčího společnosti Apple nejde o cenzuru, kde by se lidé báli vyfotit si své dítě nahé ve vaně. Cílem je skutečně potírání sexuálních predátorů.

Apple se také pyšní tím, že jeho systém má extrémně nízkou chybovost, kde je pravděpodobnost označení nezávadného obrázku jedna ku miliardě za rok. Dalším mechanismem pro ochranu veřejného blaha je cenzura zasílaných zpráv. I v případě zpráv bude chytrý algoritmus vyhledávat konkrétně závadné věty či slovní spojení a upozorňovat na to Apple. Pokud bude dítě zapleteno do konverzace, kde se bude posílat nějaký nevhodný materiál, budou o tom obratem vyrozuměni i rodiče.

Zdroj: Novinky.cz (odkaz)